- Sztuczna inteligencja stawia przed nami ogromny potencjał, ale także znaczące wyzwania etyczne, koncentrując się na kontroli i zaufaniu do systemów AI.

- Giganci technologiczni, posiadający ogromne zbiory danych, są kluczowymi graczami, ale budzą obawy dotyczące prywatności danych i uprzedzeń AI, szczególnie w technologiach predykcyjnych i rozpoznawania twarzy.

- Uprzedzenia AI odzwierciedlają społeczne uprzedzenia, reprodukowane przez wadliwe zbiory danych, często niekorzystne dla marginalizowanych grup.

- Istnieje pilna potrzeba regulacji podobnych do RODO, aby ustanowić zasady zarządzania AI, przejrzystości i odpowiedzialności.

- Wzmocnione rady etyczne powinny kierować etycznym rozwojem AI, zapewniając, że różnorodne głosy są brane pod uwagę w procesach decyzyjnych.

- Przejrzystość i zrozumiałość systemów AI są niezbędne, aby zapewnić sprawiedliwe i słuszne wyniki wpływające na podstawowe prawa.

- Publiczna znajomość AI jest kluczowa dla świadomego zaangażowania w etykę AI, umożliwiając społeczeństwu wpływanie i kierowanie postępem technologicznym.

- Odpowiedzialne wykorzystywanie AI wymaga wiedzy, rzecznictwa i zaangażowania w zapewnienie, że technologia przynosi korzyści całej ludzkości.

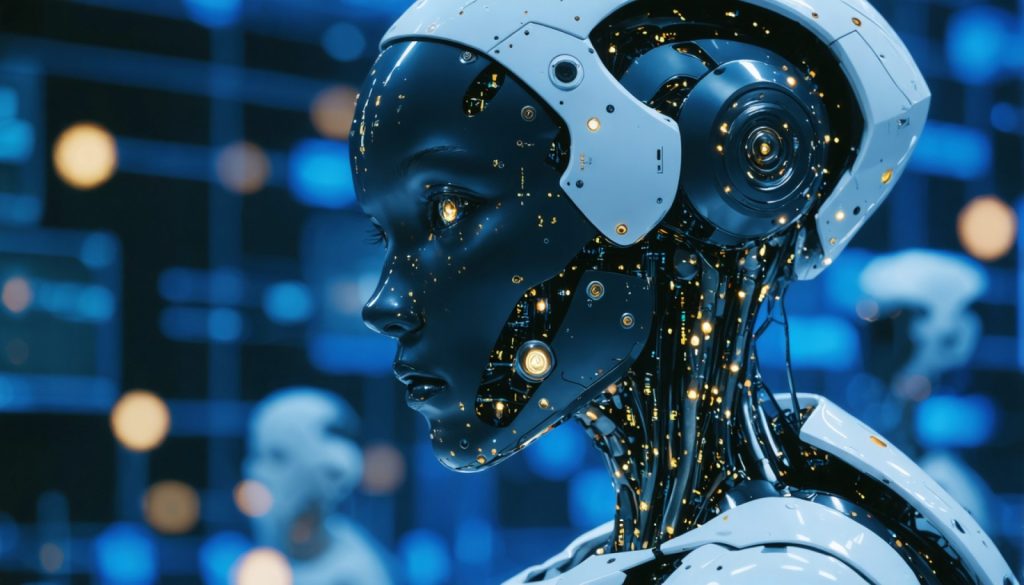

Wśród nieustannego szumu innowacji, sztuczna inteligencja wznosi się—olśniewający latarnia potencjału lub puszka Pandory czekająca na otwarcie. Mega-korporacje, te wszechwiedzące wieże strażnicze Doliny Krzemowej, posługują się tą mocą z finezją wirtuozów. Jednakże, gdy orchestrują symfonię AI, pojawia się kakofonia etycznych obaw. W sercu tej dyskusji leży pilny dylemat: Kto naprawdę kontroluje te inteligentne algorytmy i czy społeczeństwo może im zaufać?

Każdy niuans wpływu AI to gobelin, którego jeszcze nie udało nam się w pełni rozwiązać. Mimo to, większość nici prowadzi do kilku gigantów technologicznych. Ich zbiory danych mogłyby sprawić, że dystopia Orwella wydaje się urokliwa. Te firmy posiadają spostrzeżenia tak wyrafinowane, że mogłyby przewidzieć twój wybór śniadania na podstawie cyfrowego odcisku palca. Jednak taka skoncentrowana moc wymaga kontroli, ponieważ uprzedzenia zakorzenione w systemach AI to nie tylko efemeryczne problemy—są to echa społecznych niesprawiedliwości rozbrzmiewających przez algorytmy.

Rozważ to: uprzedzenie AI to nie tylko błąd; to społeczne blizny odzwierciedlające się na chipach krzemowych i sieciach neuronowych. Historyczne uprzedzenia zyskują nowe życie w obciążonych uprzedzeniami strumieniach danych, które uczą te systemy. Technologia rozpoznawania twarzy, na przykład, ma trudności z identyfikowaniem osób o ciemniejszym odcieniu skóry—wyraźne przypomnienie o nierównościach, których same dane nie mogą zlikwidować. Technologie obiecują wygodę, ale mogą podstępnie wzmacniać podziały, które twierdzą, że łączą.

Z pilnością dorównującą gorączce złota, giganci technologiczni wprowadzają innowacje na świat, często stawiając na pierwszym miejscu szybkość kosztem bezpieczeństwa. Mantra „działaj szybko i łam rzeczy” to relikt minionych er technologicznych, który teraz tańczy niebezpiecznie blisko przepaści. Wyobraź sobie AI błędnie diagnozującą stan zdrowia lub algorytmicznego strażnika systematycznie odmawiającego możliwości marginalizowanym grupom. To pościg z wysoką prędkością, gdzie kosztem jest nic mniej jak godność ludzka i równość.

Regulacja wisi jako zarówno balsam, jak i latarnia. Powinna wprowadzić nową epokę zarządzania AI z rygorystycznymi wytycznymi, podobnymi do transformacyjnego RODO dla prywatności danych. Wzmocnione rady etyczne powinny powstać, żywe i różnorodne—bliźniacze latarnie kierujące etycznym użyciem AI. Te organy, jednoczące głosy z różnych dziedzin, egzekwowałyby odpowiedzialność, oświetlając ścieżki, którymi ci techniczni giganci nie odważają się iść sami.

Przejrzystość w AI to nie tylko luksus, ale konieczność. Systemy wpływające na podstawowe prawa muszą być rozłożone na czynniki pierwsze, aż ich logika stanie się jasna, a ich osądy sprawiedliwe. Wyobraź sobie systemy AI wyjaśnione, a nie zmitologizowane—gdzie użytkownicy naprawdę rozumieją, jak podejmowane są kluczowe decyzje w ich życiu.

Ostatecznie rozwiązanie leży nie tylko w nadzorze i regulacjach, ale w rękach społeczeństwa—populacji wyposażonej w znajomość AI, gotowej do zaangażowania się w etyczne pytania jutra. Wzmocnieni obywatele mogą kierować debatą na temat AI, domagając się sprawiedliwszej przyszłości, w której technologia służy całej ludzkości.

Podczas gdy przechodzimy po tej algorytmicznej linie, potencjał AI może wydawać się przytłaczający. Jednak poprzez wiedzę, rzecznictwo i może odrobinę nadziei, społeczeństwo może mądrze i inkluzywnie korzystać z tej mocy. W końcu kod, który definiuje jutro, pisany jest przez wybory, które podejmujemy dzisiaj.

Etyczny dylemat AI: Nawigacja w przyszłości technologii z przejrzystością

Zrozumienie kontroli i zaufania w AI

Pytania o kontrolę i zaufanie w AI są kluczowe. W miarę jak giganci technologiczni rozwijają coraz bardziej zaawansowaną AI, zrozumienie, kto kontroluje te algorytmy, staje się niezbędne. Koncentracja mocy rodzi pytania o przejrzystość i motywacje stojące za tymi postępami.

Uprzedzenia AI: Utrzymujące się wyzwanie

Uprzedzenia AI to dobrze udokumentowany problem. Uprzedzenia w AI to nie tylko techniczny błąd, ale odzwierciedlenie istniejących społecznych uprzedzeń. Znanym przykładem są technologie rozpoznawania twarzy, które wykazały wyższe wskaźniki błędów dla osób o ciemniejszym odcieniu skóry (https://www.nature.com). Takie uprzedzenia mogą podtrzymywać dyskryminację, jeśli zostaną pozostawione bez kontroli, podkreślając potrzebę etycznego rozwoju AI.

Równoważenie innowacji i bezpieczeństwa

Kultura „działaj szybko i łam rzeczy” w branży technologicznej priorytetowo traktuje innowacje, ale może pomijać bezpieczeństwo. Szybkie wdrażanie AI bez dokładnych testów stwarza ryzyko, takie jak błędne diagnozy medyczne lub systematyczne uprzedzenia w zatrudnieniu i innych obszarach.

Jak poprawić przejrzystość i odpowiedzialność AI

1. Edukować i wzmacniać społeczeństwo: Zwiększenie znajomości AI wśród ogółu społeczeństwa może pomóc jednostkom lepiej zrozumieć wpływ AI i angażować się w dyskusje na temat etycznego użycia.

2. Ustanowić silniejsze regulacje: Wprowadzić ramy regulacyjne podobne do RODO dla AI, koncentrując się na przejrzystości i odpowiedzialności. Rady etyczne mogą kierować firmami, zapewniając uwzględnienie różnorodnych perspektyw.

3. Zakres przejrzystości: Firmy technologiczne powinny jasno wyjaśniać systemy AI, pozwalając użytkownikom zrozumieć procesy decyzyjne, które ich dotyczą.

4. Niezależne audyty: Firmy powinny poddawać się regularnym, niezależnym audytom w celu zapewnienia zgodności z wytycznymi etycznymi, podobnie jak audyty finansowe.

Spostrzeżenia i trendy w branży

Branża AI szybko się rozwija, z nowymi trendami podkreślającymi etyczny rozwój AI, takimi jak dążenie do systemów z człowiekiem w pętli, gdzie ludzie zachowują nadzór nad decyzjami AI. Dodatkowo, rozwój wyjaśnialnej AI ma na celu demistyfikację algorytmów, czyniąc AI bardziej przejrzystą i zrozumiałą.

Zalety i wady rozwoju AI

Zalety:

– Efektywność i wygoda: AI może usprawnić procesy w opiece zdrowotnej, logistyce i obsłudze klienta, oferując zwiększoną efektywność (https://www.ibm.com).

– Potencjał innowacji: Nowe możliwości w spersonalizowanej medycynie, inteligentnych miastach i innych obszarach napędzanych przez AI.

Wady:

– Uprzedzenia i dyskryminacja: Ryzyko podtrzymywania społecznych uprzedzeń i dyskryminacji.

– Obawy dotyczące prywatności: Potencjalne nadużycie danych osobowych zbieranych do szkolenia AI.

Rekomendacje do działania

– Domagaj się przejrzystości: Konsumenci powinni wymagać od firm bardziej przejrzystych praktyk i zrozumienia procesów AI, które ich dotyczą.

– Angażuj się w dyskusje polityczne: Bądź na bieżąco i uczestnicz w dyskusjach na temat polityki i etyki AI.

– Wspieraj inkluzyjność w rozwoju AI: Zachęcaj różnorodne zespoły w rozwoju technologicznym, aby zapewnić, że systemy AI są dobrze zrównoważone i mniej stronnicze.

Aby uzyskać więcej informacji na temat rozwoju AI i etyki, odwiedź IBM lub Nature w poszukiwaniu wiarygodnych źródeł i bieżących badań.

Skupiając się na etycznych praktykach AI i świadomym zaangażowaniu publicznym, społeczeństwo może zapewnić, że technologia służy wszystkim, prowadząc nas ku przyszłości, w której AI jest narzędziem równości i postępu.